Comment l’IA traduit le langage des neurones

Grâce aux progrès de la neuro-imagerie couplés à la puissance des nouveaux algorithmes, les chercheurs parviennent à analyser les ondes cérébrales d’une personne pour reconstruire les mots qu’elle entend ou les images qu’elle voit. Fascinant.

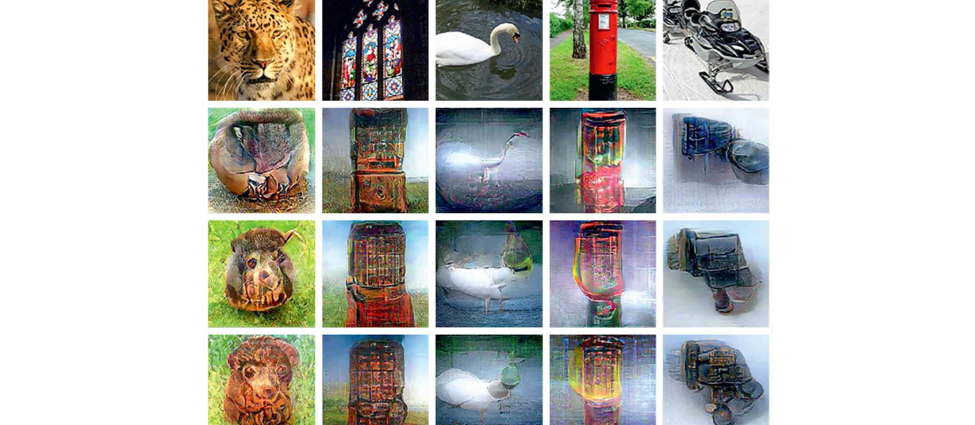

Les images (première ligne horizontale) regardées par des volontaires placés dans un appareil d’IRM sont restituées par trois algorithmes différents (lignes 2 à 4) à partir des données de neuro-imagerie enregistrées pendant leur visionnage.

Cet article est extrait du mensuel Sciences et Avenir – La Recherche n°910, daté décembre 2022.

La chose est à peine croyable, mais il est aujourd’hui possible, presque littéralement, de lire dans les pensées. Pour être précis, on dira plutôt “décoder des contenus cognitifs dans le cerveau “, mais les résultats sont là : images, mots lus ou entendus, mouvements, émotions même… Dans le cerveau, tout commence à se voir, jusqu’aux sentiments intimes, grâce aux progrès de la neuro-imagerie couplés à des puissances de calcul décuplées ces dernières années.

“L’idée, c’est qu’à n’importe quelle activité cognitive correspond une certaine configuration d’activation du cerveau, pose Bertrand Thirion, chercheur de l’équipe Mind à l’Institut national de recherche en sciences et technologies du numérique (Inria). Or, si l’on peut observer l’activité de votre cerveau, on peut faire le chemin en sens inverse et dire quelle est l’activité cognitive correspondant à telle activation neuronale ; et ainsi, reconstruire une image que vous voyez, ou que vous imaginez, ou encore des phrases avec certaines sémantiques.”