Apple détaille les gestes et les manipulations dans visionOS

Pour Apple, les interactions oculaires et gestuelles avec le Vision Pro sont à classer dans la même catégorie que la souris pour le Mac, la molette tactile pour l’iPod ou l’écran multitouch pour l’iPhone : un nouveau paradigme pour manipuler une interface. Si les yeux permettent de pointer précisément les éléments de l’interface de visionOS, les doigts servent à cliquer et à saisir ces mêmes éléments.

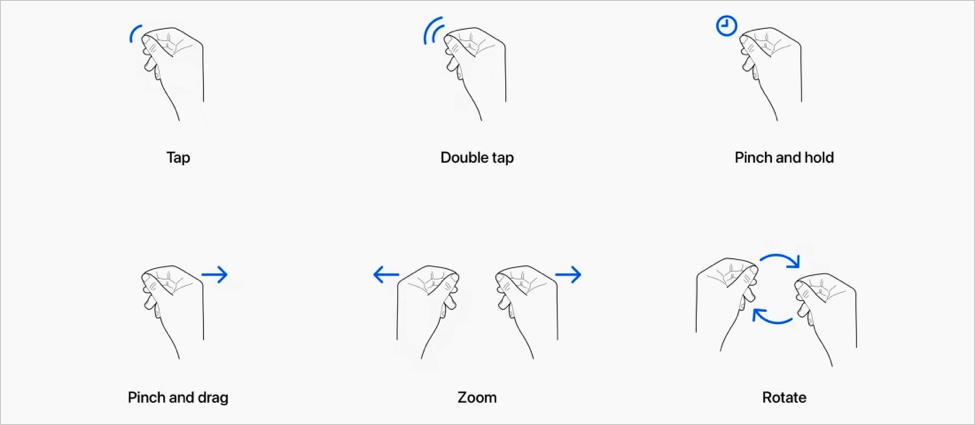

Apple a mis au point plusieurs gestes qui demanderont probablement un peu d’entraînement pour les utiliser naturellement. Dans une session de la WWDC, le constructeur détaille ces gestes : cliquer, double-cliquer, maintenir, glisser, zoomer, effectuer une rotation. Le panneau ci-dessus regroupe tous les gestes en question.

Le zoom dans une image s’annonce particulièrement saisissant : le geste va agrandir la photo à partir de l’endroit où les yeux se sont posés. Autre exemple de cette symbiose entre les yeux et les doigts : le curseur d’un outil (un feutre par exemple) se place à l’endroit du regard après un clic, ce qui permet de le contrôler très facilement.

Cette vidéo permet au passage de voir comment on pourra griffonner ou dessiner avec le Vision Pro.

Le suivi des yeux n’est pas seulement utilisé pour cibler des éléments, il fournit aussi une plus grande granularité de localisation pour les interactions.

visionOS peut également prendre en compte des interactions directes permettant d’interagir avec une surface virtuelle, qu’il s’agisse d’une page web pour scroller dans son contenu, ou encore pour taper sur le clavier virtuel. Il est même possible de « prendre » un objet entre les mains pour l’agrandir.

Les interactions avec les applications dans visionOS ne seront évidemment accompagnées d’aucun retour tactile. Pour compenser, Apple recommande de s’inspirer des objets réels et de leur fonctionnement via des animations (comme les touches d’un clavier qui s’enfoncent) et des sons (le bruit des touches).